Les limites de l'IA - Sommes-nous à l'aube d'un plateau technologique ?

Les promesses et la réalité.

L'intelligence artificielle, qui semblait promise à une croissance exponentielle illimitée, montre aujourd'hui des signes de ralentissement qui interpellent les experts du secteur. Cette situation inattendue soulève des questions fondamentales sur l'avenir de cette technologie révolutionnaire et les directions que devront prendre les recherches futures.

Le constat d'un ralentissement

Au cœur de cette préoccupation se trouve OpenAI, l'un des leaders mondiaux de l'IA. Des sources internes révèlent que leur prochain modèle, nom de code Orion, ne présente pas les améliorations spectaculaires attendues par rapport à son prédécesseur. Plus troublant encore, sur certaines tâches spécifiques, les performances ne montrent aucune amélioration significative. Cette situation est d'autant plus remarquable que Ilya Sutskever, co-fondateur de l’entreprise, a récemment confirmé ce changement de paradigme. Selon lui, si les années 2010 ont été marquées par une progression constante basée sur l'augmentation des ressources de calcul et des données d'entraînement, nous entrons désormais dans une nouvelle ère qui nécessite une approche différente.

Les défis de l'entraînement

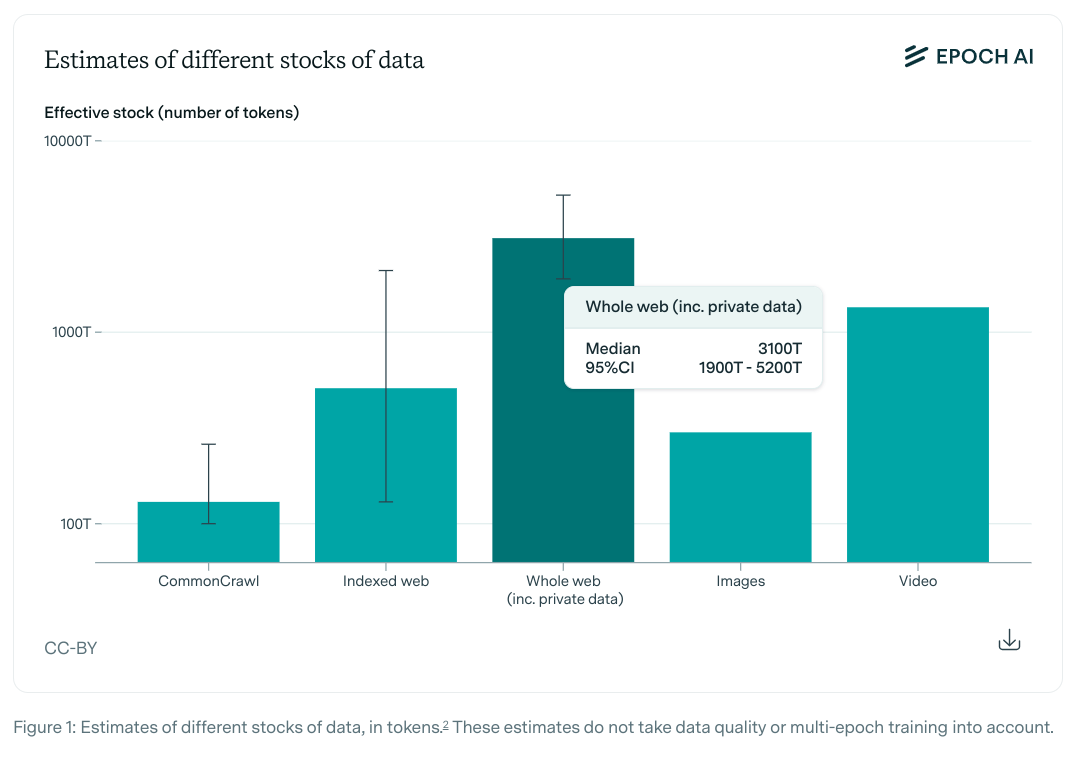

L'un des obstacles majeurs auxquels se heurtent les développeurs d'IA est la raréfaction des données textuelles de qualité disponibles pour l'entraînement des modèles. Les chercheurs d'Epoch AI ont même quantifié ce problème, prédisant un épuisement total des textes publics utilisables entre 2026 et 2032. Face à cette pénurie annoncée, les entreprises explorent diverses alternatives. OpenAI, par exemple, s'oriente vers l'utilisation de données synthétiques, générées par d'autres modèles. Cette approche soulève cependant des inquiétudes quant au risque d'un "effondrement du modèle" après plusieurs cycles d'entraînement récursif.

Les pistes d'évolution

La communauté scientifique explore actuellement plusieurs voies prometteuses pour surmonter ces limitations. L'une d'entre elles consiste à développer les capacités de raisonnement des modèles, plutôt que de se concentrer uniquement sur l'acquisition de nouvelles connaissances. Toutefois, les recherches récentes montrent que même les plus avancés d’entre eux peuvent être facilement induits en erreur. Une autre approche intéressante est celle de la distillation des connaissances, où des réseaux plus grands transmettent leur savoir à des réseaux plus petits, permettant une meilleure concentration de l'information pertinente. La solution pourrait venir d'un changement radical de perspective. Microsoft montre déjà la voie avec ses modèles de langage spécialisés, conçus pour des tâches spécifiques. Cette méthode marque potentiellement la fin de l'ère des modèles généralistes au profit d'une spécialisation accrue, similaire à celle observée dans le monde académique. Cette évolution vers la spécialisation pourrait représenter un tournant majeur dans le développement de l'IA. Plutôt que de chercher à créer des modèles toujours plus grands et plus généralistes, l'avenir pourrait appartenir à des IA hautement spécialisées, chacune excellant dans son domaine particulier.

Ce plateau apparent dans le développement des modèles de langage ne marque pas nécessairement un échec, mais plutôt une transition vers une nouvelle phase de maturité. Il nous rappelle que l'innovation technologique n'est pas toujours linéaire et que les véritables avancées nécessitent souvent de repenser fondamentalement nos approches. Cette situation pourrait même s'avérer bénéfique, forçant la communauté de l'IA à explorer des voies alternatives plus prometteuses à long terme. L'ère de la simple augmentation des ressources de calcul touche peut-être à sa fin, mais elle ouvre la voie à une période d'innovation plus subtile et potentiellement plus révolutionnaire.