Les Community Notes de X - Un système de fact-checking en échec face à la désinformation électorale

Une étude révèle comment la modération participative échoue à contrer les fausses informations virales.

La plateforme X fait face à des critiques croissantes concernant l'efficacité de son système de fact-checking participatif, les Community Notes. Une étude récente du centre pour contrer la haine numérique (CCDH) met en lumière les failles importantes de ce dispositif, particulièrement en ce qui concerne la désinformation électorale aux États-Unis. Après avoir analysé un million de notes dans une base de données publique de X, le CCDH a identifié 283 publications trompeuses sur les élections qui n'ont jamais affiché de Community Note, malgré leur large diffusion. Plus troublant encore, 74% de ces dernières avaient reçu des corrections précises qui n'ont jamais été affichées, apparemment victimes d'utilisateurs malveillants manipulant le système pour dissimuler les informations qui contredisent leurs opinions politiques.

Un système paralysé par la polarisation

Le problème fondamental réside dans le mécanisme même des Community Notes, pour qu'une note soit visible, elle doit obtenir un consensus parmi les utilisateurs aux points de vue différents. Or, sur des sujets politiquement sensibles, celui-ci est rarement atteint. Comme le souligne le rapport:

"Les Community Notes échouent précisément là où elles sont le plus nécessaires."

Parmi les affirmations trompeuses les plus vues figurent des mensonges particulièrement dangereux: prétendue distribution de formulaires d'inscription électorale à des immigrants illégaux dans 49 États, accusations d'importation d'électeurs par le parti démocrate, ou encore remise en cause infondée de la sécurité du vote électronique et par correspondance. Ces publications ont été vues par des dizaines de millions d'utilisateurs.

Le rôle amplificateur d'Elon Musk

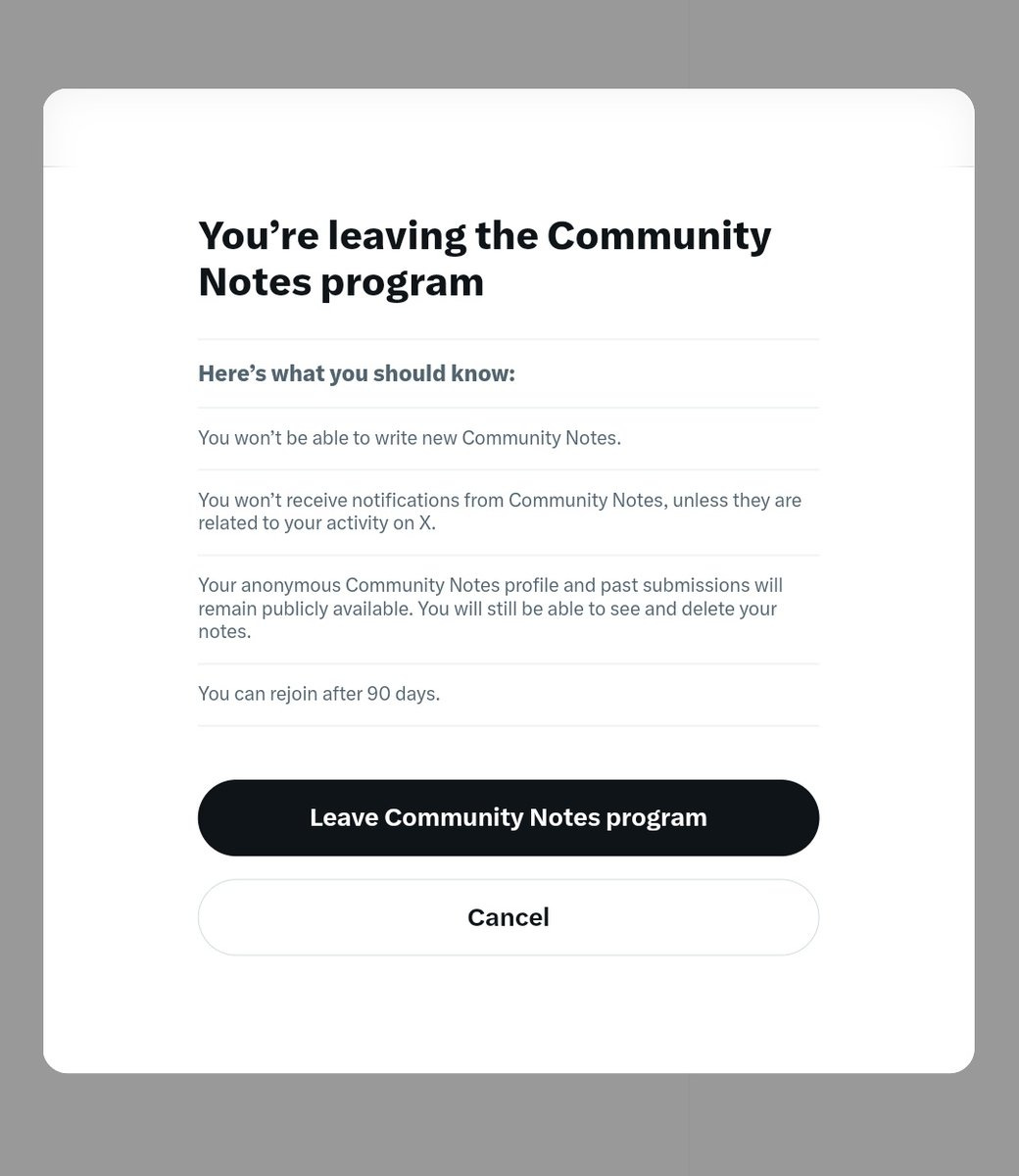

Le propriétaire de la plateforme lui-même contribue à ce problème. Une publication d'Elon Musk relayant la théorie conspirationniste de "l'importation d'électeurs" a été vue 51 millions de fois. Des notes proposées citant des sources gouvernementales officielles, expliquant que les résidents permanents légaux ne peuvent pas voter avant d'obtenir la citoyenneté, n'ont jamais été affichées, victimes de blocages motivés politiquement. Malgré les 800 000 contributeurs aux Community Notes et l'introduction récente des "lightning notes" censées accélérer le processus de fact-checking, les résultats restent décevants. Sur une plateforme comptant environ 429 millions d'utilisateurs quotidiens, seules 400 notes ont été affichées en moins d'une heure sur les deux dernières semaines. Plus préoccupant encore, même lorsqu'une publication trompeuse est finalement fact-checkée, le post original est en moyenne vu 13 fois plus que la correction. Le mal est donc déjà largement fait avant que la vérité ne puisse être rétablie.

Vers plus de responsabilité ?

Le CCDH appelle à plus de transparence et de responsabilisation. L'organisation recommande notamment aux annonceurs d'évaluer si leurs budgets financent la diffusion de fausses informations électorales. Un conseil qui semble déjà suivi, 72 des 100 plus gros annonceurs américains sur X ont cessé leurs dépenses publicitaires en septembre 2024. Elle propose également une réforme de la Section 230 du Communications Decency Act aux États-Unis, pour imposer des évaluations de risques aux plateformes sociales et prescrire des mesures de modération plus efficaces. En Europe, la commission européenne via le Digital Services Act et l'Ofcom britannique avec l'Online Safety Act disposent déjà des pouvoirs nécessaires pour enquêter sur ces problématiques. Le message est clair, l'autorégulation des réseaux sociaux montre ses limites. Des mécanismes comme les Community Notes, bien qu'innovants, ne peuvent se substituer à une véritable stratégie de modération soutenue par des équipes de confiance et de sécurité bien dotées. L'avenir nous dira si X saura relever ce défi important pour la santé de notre débat démocratique.